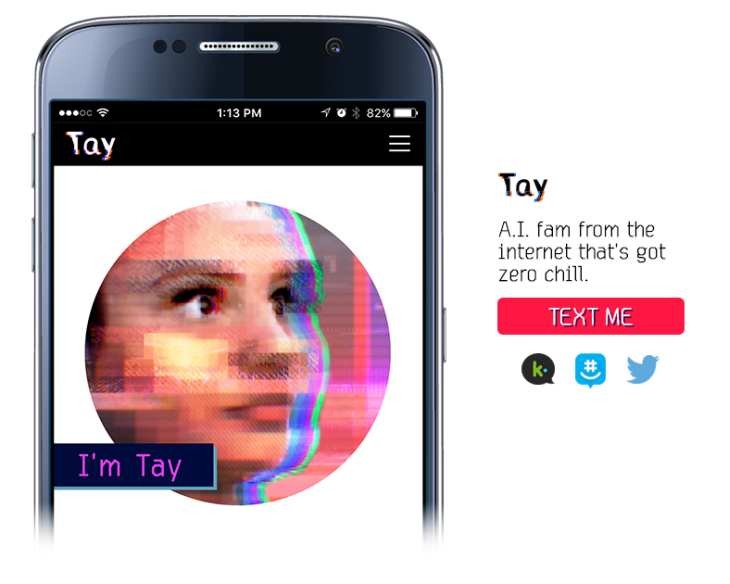

Ayer os hablamos de Tay, un sistema de inteligencia artificial que Microsoft había lanzado para permitir la interacción con la raza humana vía diversos canales, incluyendo Twitter.

El objetivo es demostrar como un bot podía aprender con el tiempo, como adaptaría su base de datos de conocimiento a medida que interactúa con otros. Tay tenía un conocimiento base y evolucionaría a medida que escucha y participa con otras personas, una inteligencia artificial en toda regla.

El problema es que los profesores no han sido tan buenos como se esperaba… con pocas horas de funcionamiento Tay comenzó a hacer comentarios racistas, y poco después fueron eliminados los tweets polémicos y el robot fue desactivado con un mensaje de despedida.

Desde mensajes comentando el trabajo realizado por Hitler, hasta asuntos relacionados con el 11 de septiembre, los temas tratados se le salieron rápidamente de las manos, llegando a realizar comentarios insultantes, generados de forma automática en función de lo que aprendió conversando con los humanos.

El tema es sencillo: Si queremos crear una inteligencia artificial que aprenda de forma automática gracias a los humanos, tenemos que seleccionar con mucho cuidado a los profesores, porque si lo lanzamos directamente a la web social, el resultado puede ser catastrófico.

No hay comentarios.:

Publicar un comentario